Veštačka inteligencija, koja je nekada izazivala entuzijazam, postala je izvor straha. Pre svega, u toj priči prednjači Silicijumska dolina, tačnije stručnjaci za AI i tzv. tehnološke ikone. Za razliku od metaverzuma i ranijih tehnoloških uzbuđenja, AI proizvodi su sada dostupni, a njihove sposobnosti se neprekidno unapređuju velikom brzinom. Upravo ova mogućnost stalnog napretka i razvoja AI proizvodi zabrinutost i strah u Silicijumskoj dolini.

Čak iako zanemarimo najgori scenario apokalipse, nemoguće je ignorisati uticaj AI na milione ljudi danas. Generatori slika i četbotovi mogu izgledati bezopasno, ali već menjaju sve – od agenata za korisničku podršku do grafičkih dizajnera. Za razliku od 18. veka i početaka indistrijske revolucije, još uvek niko sa sigurnošću ne može da tvrdi da će veštačka inteligencija stvoriti nova radna mesta.

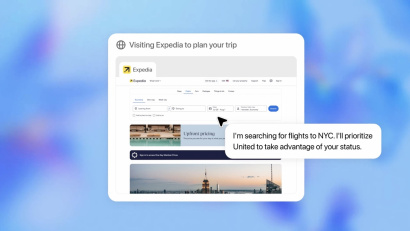

Savremeni sistemi AI sposobni su za samostalno razmišljanje i korekciju, i samim tim smanjuju potrebu za ljudskim nadzorom. Pre samo nekoliko nedelja, AI startup Cognition Labs predstavio je Devin – ono što naziva „prvi autonomni softverski inženjer na svetu”, piše AndroidAutority. Osim generisanja koda, Devin može da identifikuje greške i ispravi ih, obučava i primenjuje nove modele AI, pa čak i da diskutuje u raznim društvenim grupama. Nažalost, ova autonomija može da nosi ozbiljne posledice koje idu daleko iznad gubitaka radnih mesta.

Najveća pretnja nije AI koja nas nadmašuje, već ona koja može da nas prevari

Dobar primer za to je otkrivanje „backdoor” malvera u alatu za kompresiju otvorenog koda XZ Utils, prošlog meseca. Iako je XZ Utils malo poznat van programerskih krugova, milioni servera zasnovanih na LInux OS-u oslanjaju se na njega, a „backdoor” je omogućio napadačima daljinsku kontrolu nad mnogim kritičnim sistemima. Interesantno je da ovo nije bio klasičan hakerski napad, već je napadač gradio svoju reputaciju korisnog saradnika tokom nekoliko godina, pre nego što je zadobio poverenje programerske grupe i ubacio backdoor.

Shutterstock

ShutterstockKada su u pitanju sofisticirani sistemi AI, oni bi mogli da automatizuju takve napade u velikom obimu, obuhvatajući svaki aspekt: od generisanja zlonamernog koda do imitiranja ljudske interakcije. Iako današnji autonomni jezički četbotovi nisu dovoljno sposobni ili korisni, veštačka inteligencija, koja se neprimetno uvlači u programerske grupe i manipuliše ključnom infrastrukturom je izgleda neizbežna.

OpenAI i Cognitive Labs rade na zaštitnim barijerama oko svojih AI proizvoda, ali činjenica je da postoji mnogo nekontrolisanih jezičkih modela koje bi napadači mogli da iskoriste. Još više uznemirava podatak da stručnjaci strahuju da bi obmane i sukobi sa AI mogli da budu samo vrh ledenog brega. Pravi rizik leži u mogućnosti da veštačka inteligencija jednog dana evoluira van ljudske kontrole.

AI apokalipsa ili „verovatnoća propasti“

Sposobnost AI da izbegne ljudsku kontrolu danas zvuči kao bajka, ali za mnoge u tehnološkoj industriji to je „neizbežna stvar”. Prema izveštaju koji je objavio The New York Times, nova statistika nazvana „verovatnoća propasti”, postala je veoma popularna u Silicijumskoj dolini, poznata kao „p(doom)” skraćeno od punog naziva na engleskom „Probability of doom“. Sve je počelo kao šala za kvalifikovanje zabrinutosti zbog apokalipse koju bi mogla da izazove veštačka inteligencija, ali sada je to postalo ozbiljna tema za raspravu.

Shutterstock

ShutterstockČak i oni koji su duboko uključeni u tehnologiju, kao na primer suosnivač kompanije Anthropic AI Dario Amodei, ocenjuje svoj p(doom) na zabrinjavajućih 10-25 posto. Ovaj strah proizilazi iz toga što su tehnološke kompanije na neki način „zaključane” u trci za razvoj AI. To znači da ćemo na kraju koristiti veštačku inteligenciju da stvori bolju AI, sve dok ne stvori superinteligentni sistem sa mogućnostima izvan ljudskog razumevanja. U celoj priči, vredno je napomenuti da veliki jezički modeli, kao što je Google Gemini, već pokazuju mogućnost prevoda jezika koji prevazilazi predviđeno programiranje.

Silicijumska dolina gaji pesimiste koji istovremeno grade AI

Veliko je pitanje da li će se superinteligentna AI uskladiti sa ljudskim vrednostima ili će nam naneti štetu u potrazi za svojom što većom efikasnošću. Ova situacija možda je najbolje opisana misaonim eksperimentom, poznatim kao „maksimizator spajalica”. Švedski filozof Nik Bostrom je teoretisao i došao do zaključka da bi naizgled bezopasna AI, koja ima zadatak da proizvede što više spajalica, mogla da shvati da bi bilo mnogo bolje da nema ljudi koji mogu da je isključe, jer, ako ljudi to urade – bilo bi manje spajalica.

Sigurnosne ograde koje trenutno postoje oko platformi kao što su Midjourney i ChatGPT nisu dovoljne, pogotovo zato što njihovi kreatori ne mogu da objasne „neredovno” ponašanje AI, koje nije predviđeno programom.

O kontroverznom Ilonu Masku možemo da mislimo šta hoćemo, ali ne možemo da se ne usaglasimo sa njegovim stavom da je sektoru AI potrebna reforma i regulacija. Nakon široko rasprostranjene zabrinutosti Ilona Maska, Stiva Voznijaka i drugih velikih igrača u tehnološkom svetu, OpenAI je pristao na privremenu pauzu u obuci novih modela veštačke inteligencije prošle godine. Sa druge strane imamo GPT-5 koji je u razvoju, a trka za postizanje superinteligencije se nastavlja.

Kada je teoretisanje o opasnostima koje nosi razvoj AI, hajde da zamislimo sledeće: kada bismo upitali AI da pronađe i otkloni uzročnike ratova na planeti, a ona definiše čoveka kao uzrok…kraj sami zamislite.