OpenAI tvrdi da je njihov najnoviji AI model, kodnog imena “Strawberry” i objavljen kao o1-preview, sposoban za “rezonovanje”. Ali razumevanje kako funkcioniše njegov misaoni proces, očigledno je nešto što tvorac ChatGPT-a ozbiljno želi da zadrži van domašaja.

Kako izveštava Ars Technica, OpenAI sada preti da će zabraniti korisnike koji pokušaju da navedu veliki jezički model da otkrije kako razmišlja — očigledan primer kako je kompanija odavno napustila svoju originalnu viziju zagovaranja otvorenog AI koda.

Prema navodima na društvenim mrežama, korisnici primaju elektronsku poštu od startapa koji podržava Microsoft, u kojoj ih obaveštavaju da su njihovi zahtevi upućeni ChatGPT-u “označeni zbog pokušaja zaobilaženja sigurnosnih mera”.

Kršenje sigurnosnih mera može rezultirati gubitkom pristupa GPT-4o

“Dodatna kršenja ove politike mogu rezultirati gubitkom pristupa GPT-4o sa rezonovanjem”, navodi se u porukama.

Ars Technica

Ars TechnicaOvo pooštravanje je više nego ironično s obzirom na to da je veliki deo hajpa oko Strawberry-ja izgrađen oko njegovog “lanca misli” koji omogućava AI-u da artikuliše kako je došao do odgovora, korak po korak. Tehnička direktorka OpenAI-a, Mira Murati, nazvala je ovo “novim paradigmom” za tehnologiju.

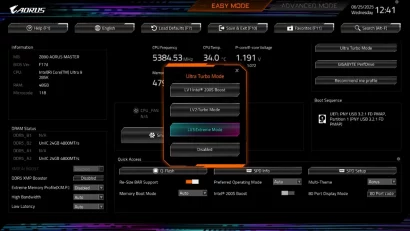

Izveštaji o tome šta zapravo izaziva kršenje pravila variraju. Kako je Ars otkrio, neki korisnici tvrde da je upotreba izraza “reasoning trace” ono što ih je dovelo u nevolju. Drugi kažu da je čak i korišćenje same reči “reasoning” bilo dovoljno da alarmira OpenAI-ove sisteme. Korisnici i dalje mogu da vide ono što je suštinski sažetak misaonog procesa Strawberry-ja, ali je on sastavljen od strane drugog AI modela i znatno je ublažen.

U blog postu, OpenAI tvrdi da mora da sakrije lanac misli kako ne bi morao da postavi filter na to kako njegov AI razmišlja, u slučaju da kaže nešto što nije u skladu sa politikama bezbednosti dok razmišlja naglas. Na taj način, developeri mogu bezbedno da vide njegov “sirovi” misaoni proces iza kulisa.

Ali kako kompanija slobodno priznaje, ova mera takođe pomaže da se održi “konkurentska prednost”, sprečavajući konkurente da pokušaju da se okoriste njenim dostignućima, piše Futurism.

Nema komentara 😞

Trenutno nema komentara vezanih za ovu vest. Priključi se diskusiji na Benchmark forumu i budi prvi koje će ostaviti komentar na ovaj članak!

Pridruži se diskusiji