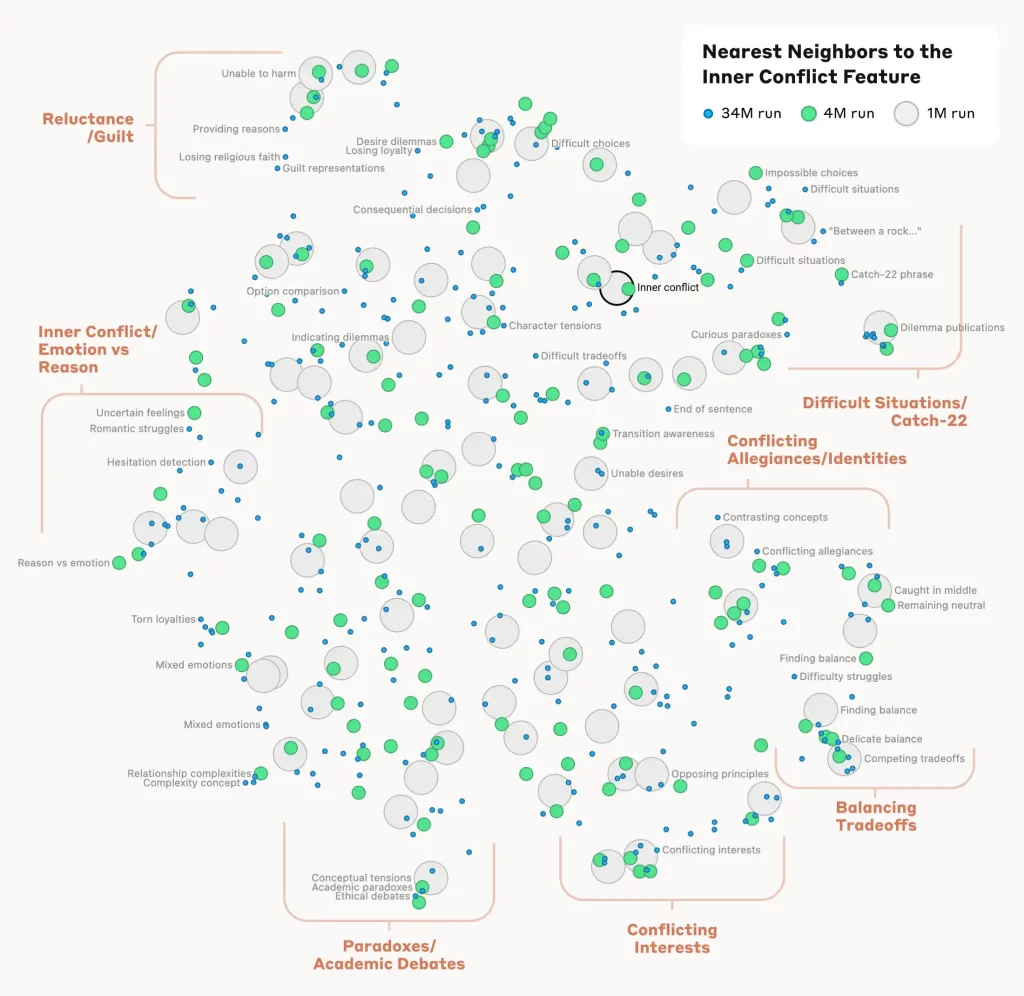

Stalna poboljšanja AI modela mogla bi navesti ljude da pomisle kako smo napokon u potpunosti shvatili kako veliki jezički modeli (LLM) funkcionišu. Međutim, oni i dalje ostaju jedna od najmanje razumljivih tehnologija široke primene. Kompanija Anthropic pokušava da promeni to pomoću nove tehnike pod nazivom “praćenje kola” (circuit tracing), koja je pomogla istraživačima da mapiraju unutrašnje procese modela Claude 3.5 Haiku.

Ova tehnika omogućava istraživačima da prate način na koji AI model postepeno formira svoje odgovore, slično kao praćenje neuronskih veza u mozgu. Anthropic ju je iskoristio kako bi zavirio u unutrašnje procese modela Claude, otkrivajući neobične, ponekad neljudske metode donošenja zaključaka – metode koje model ne bi ni priznao kada bi ga o tome pitali.

Tim je ispitao deset različitih ponašanja AI modela, a tri su se posebno izdvojila.

Prvi primer se odnosi na odgovor na pitanje: “Šta je suprotno od malog?” na različitim jezicima. Umesto da koristi odvojene procese za engleski, francuski ili kineski, model prvo utvrđuje apstraktnu suprotnost uopšteno (nešto povezano sa “veličinom”), a zatim bira odgovarajuće reči na traženom jeziku. Ovo pokazuje da Claude ne ponavlja unapred zapamćene prevode, već primenjuje apstraktne koncepte na više jezika, slično kao ljudi.

Drugi primer se odnosi na matematiku. Kada se modelu postavi pitanje koliko je 36 + 59, umesto standardne metode sabiranja jedinica, prenosa desetica itd., on koristi neobičan pristup. Najpre približno sabira brojeve kao „40 i 60“ ili „57 i 36“, dolazeći do „92 otprilike“. Istovremeno, drugi deo modela obraća pažnju na cifre 6 i 9 i zaključuje da zbir mora da se završava na 5. Kombinovanjem ovih koraka, Claude dolazi do tačnog odgovora – 95. Međutim, ako ga pitate kako je rešio zadatak, model će samouvereno opisati klasičnu školsku metodu, skrivajući svoj stvarni proces razmišljanja.

Najčudniji primer se odnosi na poeziju. Kada mu je zadatak bio da napiše rimu sa zadatim stihom „He saw a carrot and had to grab it“, Claude je već pri obradi reči „grab it“ odabrao da će reč „rabbit“ biti kraj rime. Tek nakon toga je formirao ostatak stiha, dobijajući: „His hunger was like a starving rabbit.“ Ovo sugeriše da LLM modeli možda imaju više predumišljaja nego što smo ranije verovali i da ne konstruišu rečenice isključivo predviđanjem sledeće reči jednu po jednu.

Ova otkrića predstavljaju veliki korak napred jer dokazuju da konačno možemo delimično videti kako ovi modeli funkcionišu. Ipak, istraživač Džošua Batson iz Anthropica priznaje da je ovo tek „vrh ledenog brega“. Praćenje čak i jednog odgovora može trajati satima, a pred istraživačima je još mnogo posla kako bi u potpunosti razumeli način na koji LLM modeli donose odluke, piše Tech Spot.

Nema komentara 😞

Trenutno nema komentara vezanih za ovu vest. Priključi se diskusiji na Benchmark forumu i budi prvi koje će ostaviti komentar na ovaj članak!

Pridruži se diskusiji