Dana 16. maja 2023. godine, Sam Altman, šarmantni, blago govoreći, večito optimistični milijarder i CEO OpenAI-a, i ja smo stajali pred Pododborom za nadzor AI-a američkog Senata. Bili smo u Vašingtonu, na vrhuncu AI manije. Altman, tada 38-godišnjak, bio je zaštitno lice svega toga.

Odrastao u Sent Luisu, Misuri, Altman je napustio Stanford i postao predsednik izuzetno uspešnog startup inkubatora Y Combinator pre nego što je napunio 30 godina. Nekoliko meseci pre saslušanja, proizvod njegove kompanije, ChatGPT, osvojio je svet. Tokom leta 2023. godine, Altman je bio tretiran kao rokenrol zvezda, obilazeći svet, sastajući se sa premijerima i predsednicima širom sveta.

Američki senator Kirsten Sinema rekla je: “Nikada nisam srela nikoga tako pametnog kao što je Sam… On je introvertan i stidljiv i skroman… Ali… veoma dobar u formiranju odnosa sa ljudima na Kapitol Hilu i… može pomoći ljudima u vladi da razumeju AI.” Portreti u medijima u to vreme prikazivali su mladog Altmana kao iskrenog, talentovanog, bogatog i zainteresovanog za ništa drugo osim za unapređenje čovečanstva. Njegovi česti predlozi da AI može transformisati globalnu ekonomiju izazivali su salvu pozitivnih reakcija kod svetskih lidera.

Senator Ričard Blumental je pozvao nas dvojicu (i Kristinu Montgomeri iz IBM-a) u Vašington da razgovaramo o tome šta bi trebalo uraditi po pitanju AI-a, “dvojne tehnologije” koja je imala ogroman potencijal, ali je mogla izazvati i ogromnu štetu – od cunamija dezinformacija do omogućavanja proliferacije novih bioloških oružja. Tema je bila AI politika i regulacija. Zakleli smo se da ćemo govoriti istinu, i ništa osim istine.

Altman je predstavljao jednu od vodećih AI kompanija; ja sam bio tamo kao naučnik i autor, poznat po svom skepticizmu prema mnogim stvarima vezanim za AI. Pronašao sam Altmana iznenađujuće angažovanim. Bilo je trenutaka kada je izbegavao pitanja (posebno Blumentalovo “Šta vas najviše brine?”, na koje sam pritisnuo Altmana da odgovori iskrenije), ali u celini, delovao je iskreno, i sećam se da sam to rekao senatorima u to vreme. Obojica smo se snažno zalagali za regulaciju AI-a. Malo po malo, shvatio sam da smo ja, Senat, i na kraju američki narod, verovatno bili prevareni.

Godinama OpenAI je bio ime koje je asociralo na vrstu otvorenosti o nauci

U stvari, oduvek sam imao neke sumnje prema OpenAI-u. Kampanje kompanije za štampu, na primer, često su bile preterane i čak obmanjujuće, kao njihova raskošna demonstracija robota koji “rešava” Rubikovu kocku koja je imala specijalne senzore unutra. To je dobilo mnogo medijske pažnje, ali na kraju nije imalo nikakvog značaja.

Godinama, ime OpenAI – koje je impliciralo vrstu otvorenosti o nauci iza onoga što je kompanija radila – osećalo se kao laž, jer je u stvarnosti postajalo sve manje i manje transparentno. Česti nagoveštaji kompanije da je AGI (veštačka opšta inteligencija, AI koja može barem da se podudari sa kognitivnim sposobnostima bilo kog čoveka) iza ugla, uvek su mi delovali kao neosnovana buka. Ali u ličnom kontaktu, Altman je blistao; pitao sam se da li sam bio previše strog prema njemu ranije. Gledajući unazad, bio sam previše blag.

Počeo sam da se preispitujem nakon što mi je neko poslao dojavu, nešto malo, ali indikativno. U Senatu, Altman se prikazao mnogo altruističnijim nego što zaista jeste. Senator Džon Kenedi je pitao: “U redu. Zarađujete mnogo novca. Zar ne?” Altman je odgovorio: “Ne zarađujem… Dovoljno dobijam za zdravstveno osiguranje. Nemam udela u OpenAI-u,” dodajući: “Radim ovo jer to volim.” Senatorima je to bilo dovoljno.

The Guardian

The GuardianAltman nije govorio punu istinu. Nije posedovao akcije u OpenAI-u, ali je posedovao akcije u Y Combinatoru, a Y Combinator je posedovao akcije u OpenAI-u. To znači da je Sam imao indirektan udeo u OpenAI-u, što je navedeno na veb sajtu OpenAI-a. Ako je taj indirektan udeo bio vredan samo 0.1% vrednosti kompanije, što deluje verovatno, bio bi vredan skoro 100 miliona dolara.

To što je izostavio ovaj važan detalj je bio znak upozorenja. A kada je ova tema postala ponovo aktuelna, mogao je da je ispravi. Ali nije. Ljudi su voleli njegovu nesebičnu mit. (On je to potvrdio, u članku za Fortune, tvrdeći da mu nisu potrebne deonica u OpenAI-u jer je imao “dovoljno novca”.) Nedugo nakon toga, otkrio sam da je OpenAI napravio dogovor sa kompanijom za čipove u kojoj Altman ima udeo. Nesebičnost je počela da zvuči prazno.

Diskusija o novcu nije bila, gledajući unazad, jedina stvar iz našeg vremena u Senatu koja nije delovala potpuno iskreno. Mnogo važniji bio je stav OpenAI-a o regulaciji AI-a. Javno, Altman je rekao Senatu da je podržava. Realnost je mnogo složenija.

Iza zatvorenih vrata, Altmanovi lobisti stalno guraju za slabiju regulaciju AI-a ili da je uopšte nema

S jedne strane, možda mali deo Altmana zaista želi regulaciju AI-a. Voli da parafrazira Oppenheimera (i dobro je svestan da deli rođendan sa liderom Manhattan projekta), i prepoznaje da, kao nuklearno oružje, AI predstavlja ozbiljne rizike za čovečanstvo. Njegovim rečima, izgovorenim u Senatu (iako posle malo podsticanja od mene): “Gledajte, pokušali smo da budemo vrlo jasni u vezi sa veličinom rizika ovde… Moji najgori strahovi su da izazovemo značajnu – mi, polje, tehnologija, industrija – značajnu štetu svetu.”

Pretpostavljam da Altman ne želi da živi u kajanju i sramoti. Ali iza zatvorenih vrata, njegovi lobisti stalno guraju za slabiju regulaciju ili da je uopšte nema. Mesec dana nakon saslušanja u Senatu, saznalo se da OpenAI radi na razvodnjavanju AI zakona EU. Kada je otpušten iz OpenAI-a u novembru 2023. zbog “nedoslednog iskazivanja” pred odborom, nisam bio iznenađen.

U to vreme, malo ljudi je podržavalo odluku odbora da otpusti Altmana. Ogroman broj pristalica je stao uz njega; mnogi su ga tretirali kao sveca. Poznata novinarka Kara Swisher (poznata po tome što je prilično prijateljski nastrojena prema Altmanu) me je blokirala na Twitteru samo zato što sam sugerisao da odbor možda ima pravo. Altman je dobro igrao s medijima. Pet dana kasnije bio je vraćen, uz pomoć glavnog investitora OpenAI-a, Microsofta i peticije zaposlenih u podršci Altmanu.

Ali mnogo se toga promenilo od tada. U poslednjih nekoliko meseci, zabrinutost oko Altmanove iskrenosti postala je od jeretičke do moderne. Novinar Edward Zitron napisao je da je Altman “lažni prorok – lukavi varalica koji koristi svoje izuzetne sposobnosti da impresionira i manipuliše elitom Silicijumske doline”.

Ellen Huet iz Bloomberg News, u podcastu Foundering, došla je do zaključka da “kada [Altman] nešto kaže, ne možete biti sigurni da on to zaista misli”. Paris Marx je upozorio na “samoposlužnu viziju Sama Altmana”. AI pionir Geoffrey Hinton nedavno je doveo u pitanje Altmanove motive. Ja sam napisao esej pod nazivom Sam Altman Playbook, razlažući kako je uspeo da prevari toliko ljudi tako dugo, kombinacijom hajpa i prividne skromnosti.

Altman gubi poverenje

Mnoge stvari su dovele do ovog pada uverenja. Za neke je okidač bio Altmanov odnos početkom ove godine sa Scarlett Johansson, koja ga je izričito zamolila da ne pravi chatbot sa njenim glasom. Altman je nastavio da koristi drugu glumicu, ali onu koja je očigledno slična njoj po glasu, i tvitovao “Her” (referenca na film u kojem je Johansson dala glas za AI). Johansson je bila besna.

Skandal sa ScarJo bio je simbol većeg problema: velike kompanije poput OpenAI insistiraju da njihovi modeli neće raditi ako nisu obučeni na celokupnoj svetskoj intelektualnoj svojini, ali kompanije su dale malo ili nimalo naknade mnogim umetnicima, piscima i drugima koji su je stvorili. Glumica Justine Bateman opisala je to kao “najveću krađu u istoriji Sjedinjenih Država”.

The Guardian

The GuardianU međuvremenu, OpenAI dugo daje usmene izjave o vrednosti razvijanja mera za sigurnost AI-a, ali nekoliko ključnih zaposlenih zaduženih za sigurnost nedavno je napustilo kompaniju, tvrdeći da obećanja nisu ispunjena. Bivši istraživač sigurnosti OpenAI-a Jan Leike rekao je da kompanija daje prioritet sjajnim stvarima u odnosu na sigurnost, kao i drugi zaposleni koji je nedavno napustio kompanijau, William Saunders.

Suosnivač Ilya Sutskever napustio je kompaniju i osnovao novu pod nazivom Safe Superintelligence, dok je bivši zaposleni OpenAI-a Daniel Kokotajlo takođe upozorio da se obećanja o sigurnosti ne poštuju. Koliko god društvene mreže bile loše za društvo, pogrešan AI, koji bi OpenAI mogao slučajno razviti, mogao bi (kao što Altman sam napominje) biti mnogo gori.

Ućutkivanje zaposlenih nije prošlo

Nezainteresovanost koju je OpenAI pokazao za sigurnost je dodatno pogoršana činjenicom da kompanija izgleda vodi kampanju za ućutkivanje svojih zaposlenih. U maju, novinarka Kelsey Piper otkrila je dokumenta koja omogućavaju kompaniji da povrati stečene akcije od bivših zaposlenih ako ne pristanu da ne govore loše o kompaniji, praksu koju su mnogi industrijski insajderi smatrali šokantnom. Ubrzo nakon toga, mnogi bivši zaposleni u OpenAI-u potpisali su pismo na righttowarn.ai zahtevajući zaštitu za uzbunjivače i kao rezultat toga kompanija je popustila, navodeći da neće primenjivati te ugovore.

Čak se i odbor kompanije osećao prevarenim. U maju, bivša članica odbora OpenAI-a Helen Toner rekla je u podkastu Ted AI Show: “Godinama je Sam otežavao rad odbora… tako što je, znate, uskraćivao informacije, pogrešno predstavljajući stvari koje su se dešavale u kompaniji, u nekim slučajevima otvoreno lažući odbor.”

Do kraja maja, loši medijski natpisi za OpenAI i njegovog CEO-a su se nagomilali do te mere da je investitor Matt Turck objavio crtani film na X-u: “dani od poslednje lako izbegnute kontroverze OpenAI-a: 0.”

Ipak, Altman je još uvek tu, i još uvek neverovatno moćan. Još uvek vodi OpenAI i u velikoj meri je još uvek javno lice AI-a. Rekonstruisao je odbor OpenAI-a uglavnom prema svom ukusu. Čak je nedavno, u aprilu 2024, sekretar za unutrašnju bezbednost Alejandro Mayorkas otputovao da poseti Altmana, da ga regrutuje za savet bezbednosti i sigurnosti AI-a za unutrašnju bezbednost.

Mnogo je toga na kocki. Način na koji se AI sada razvija imaće trajne posledice. Altmanovi izbori mogli bi lako uticati na čitavo čovečanstvo – ne samo na individualne korisnike – na trajan način sa nesagledivim posledicama.

Već sada, kako je OpenAI priznao, njegovi alati su korišćeni od strane Rusije i Kine za stvaranje dezinformacija, verovatno sa namerom da utiču na izbore. Napredniji oblici AI-a, ako budu razvijeni, mogli bi predstavljati još ozbiljnije rizike. Šta god društvene mreže uradile, u smislu polarizacije društva i suptilnog uticaja na ljudska uverenja, velike AI kompanije mogle bi učiniti gore.

Pored toga, generativni AI, koji je OpenAI popularizovao, ima ogroman ekološki uticaj, merljiv u potrošnji električne energije, emisiji štetnih gasova i potrošnji vode. Kako je nedavno napisao Bloomberg: “AI već pravi haos u globalnim energetskim sistemima.” Taj uticaj bi mogao rasti, možda znatno, kako modeli sami postaju veći (cilj svih većih igrača). U velikoj meri, vlade se oslanjaju na Altmanove reči da će se AI na kraju isplatiti (do sada to svakako nije bio slučaj), opravdavajući ekološke troškove.

Potcenjivanje AI tehnologije bi moglo dovesti do rata

Iskreno, mislim da nećemo doći do AI-a kojem možemo verovati ako ostanemo na trenutnom putu. U međuvremenu, OpenAI je preuzeo lidersku poziciju, a Altman je u odboru za sigurnost AI-a za unutrašnju bezbednost. Njegovi saveti bi trebalo da se uzimaju sa skepsom. Altman je bar kratko pokušavao da privuče investitore za ulaganje od 7 triliona dolara u infrastrukturu oko generativnog AI-a, što bi moglo ispasti ogromno rasipanje resursa koje bi možda moglo biti bolje potrošeno negde drugde, ako (kao što ja i mnogi drugi sumnjamo) generativni AI nije pravi put do AGI [veštačke opšte inteligencije].

Konačno, precenjivanje trenutnog AI-a moglo bi dovesti do rata. Američko-kineski “čip rat” oko kontrole izvoza, na primer – u kojem SAD ograničava izvoz kritičnih GPU čipova dizajniranih od strane Nvidia, proizvedenih na Tajvanu – utiče na sposobnost Kine da napreduje u AI-u i eskalira tenzije između dve nacije. Bitka oko čipova se uglavnom temelji na pretpostavci da će AI nastaviti eksponencijalno da napreduje, iako podaci sugerišu da su trenutni pristupi možda nedavno dostigli tačku opadajućih prinosa.

Altman je možda započeo sa dobrim namerama. Možda je zaista želeo da spasi svet od pretnji AI-a, i vodi AI ka dobru. Možda je pohlepa preuzela, kao što često biva.

Nažalost, mnoge druge AI kompanije izgleda da idu putem hajpa i prečica koje je Altman zacrtao. Anthropic – formiran od strane grupe bivših zaposlenih OpenAI-a koji su bili zabrinuti da se sigurnost AI-a ne shvata dovoljno ozbiljno – izgleda sve više konkurentski usmeren prema matičnoj kompaniji, sa svim što to podrazumeva.

Ni druge AI kompanije nisu puno bolje

Startap vredan milijardu dolara Perplexity izgleda kao još jedna lekcija u pohlepi, obučavajući se na podacima koje ne bi trebalo da koristi. Microsoft je, u međuvremenu, prešao sa zagovaranja “odgovornog AI-a” na brzo izbacivanje proizvoda sa ozbiljnim problemima, pritiskajući Google da učini isto. Novac i moć kvare AI, kao što su pokvarili društvene mreže.

Jednostavno ne možemo verovati velikim, privatno držanim AI startapovima da se upravljaju na etičan i transparentan način. I ako ne možemo verovati da će se sami upravljati, sigurno ne bismo trebali dozvoliti da upravljaju svetom.

Iskreno mislim da nećemo doći do AI-a kome možemo verovati ako ostanemo na trenutnom putu. Pored korumpirajućeg uticaja moći i novca, postoji i dubok tehnički problem: veliki jezički modeli (osnovna tehnika generativnog AI-a) koje je izumeo Google i koje je proslavio Altmanov OpenAI, verovatno nikada neće biti sigurni. Oni su po prirodi nepopustljivi i neprozirni – takozvane “crne kutije” koje nikada ne možemo potpuno kontrolisati. Statističke tehnike koje ih pokreću mogu činiti neke neverovatne stvari, poput ubrzavanja programiranja računara i stvaranja verodostojnih interaktivnih likova u stilu preminulih voljenih osoba ili istorijskih ličnosti. Ali takve crne kutije nikada nisu bile pouzdane, i kao takve su loša osnova za AI kojem bismo mogli poveriti naše živote i infrastrukturu.

Rečeno to, ne mislim da bi trebalo da odustanemo od AI-a. Izrada boljeg AI-a – za medicinu, i materijalnu nauku, i klimatske nauke, i tako dalje – zaista bi mogla transformisati svet. Generativni AI verovatno neće to učiniti, ali neki budući, još nerazvijeni oblik AI-a bi mogao.

Ne treba odustati od AI tehnologije

Ironija je da najveća pretnja za AI danas mogu biti same AI kompanije; njihovo loše ponašanje i preuveličana obećanja okreću mnoge ljude protiv toga. Mnogi su spremni da vlada preuzme jaču ulogu. Prema anketi iz juna od strane Instituta za politiku veštačke inteligencije, 80% američkih birača preferira “regulaciju AI-a koja nalaže sigurnosne mere i vladin nadzor nad AI laboratorijama, umesto da se AI kompanijama dozvoli da se same regulišu”.

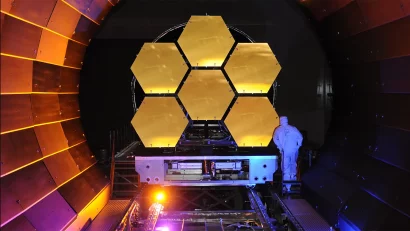

Da bismo došli do AI-a kojem možemo verovati, dugo sam se zalagao za međunarodni napor, sličan CERN-ovom konzorcijumu za fiziku visoke energije. Vreme za to je upravo sada. Takav napor, fokusiran na sigurnost i pouzdanost AI-a pre nego na profit, i na razvijanje novog seta AI tehnika koje pripadaju čovečanstvu – a ne samo nekolicini pohlepnih kompanija – mogao bi biti transformativan, piše The Guardian.

Za više od toga, građani moraju da se oglase i zahtevaju AI koji je dobar za mnoge, a ne samo za nekolicinu. Jedna stvar koju mogu garantovati je da nećemo doći do obećane zemlje AI-a ako sve ostavimo u rukama Silicijumske doline. Tehnički šefovi su zamagljivali istinu decenijama. Zašto bismo očekivali da će Sam Altman, poslednji put viđen kako krstari po Napa dolini u Koenigsegg superautomobilu od 4 miliona dolara, biti drugačiji?

Gary Marcus je naučnik, preduzetnik i autor bestselera. Bio je osnivač i CEO kompanije za mašinsko učenje Geometric Intelligence, koju je kupio Uber, i autor je šest knjiga, uključujući nadolazeću Taming Silicon Valley (MIT Press).

Ja se plašim da ćete prevazići Blic/Kurir/Informer.

Benchmark ide samo u korak sa ovim glupavim svetom….like, share, suscribe.

... i tu se svaka prica o objektivnosti zavrsila. Mis'im Gardijan rodjaci i prijatelji... :ROFLMAO::ROFLMAO::ROFLMAO:

Žalosno što je tako... Mislio sam da gledaju u drugom pravcu, a ne copy/paste?

moda/hir/ludilo/deluzija...

englezi imaju samo jednu rec za tih 4 iznad:

fad